Ressource

Évaluation de la précision du Copyleaks Détecteur IA

Une méthodologie étape par étape

Date de l'essai : 25 mai 2024

Modèle testé : V5

Nous pensons qu'il est plus important que jamais d'être totalement transparent sur les performances du détecteur AI. l'exactitude, les taux de faux positifs et de faux négatifs, les domaines à améliorer et bien plus encore pour garantir une utilisation et une adoption responsables. Cette analyse complète vise à garantir une transparence totale autour de la méthodologie de test du modèle V5 de notre AI Detector.

Méthodologie

Les équipes de science des données et d'assurance qualité de Copyleaks ont effectué des tests de manière indépendante pour garantir des résultats impartiaux et précis. Les données de test différaient des données de formation et ne contenaient aucun contenu précédemment soumis au détecteur AI pour la détection de l'IA.

Les données de test étaient constituées de textes écrits par des humains provenant d'ensembles de données vérifiés et de textes générés par l'IA à partir de divers modèles d'IA. Le test a été réalisé avec l'API Copyleaks.

Métrique

Les mesures incluent la précision globale basée sur le taux d'identification de texte correct et incorrect, en plus du ROC-AUC (Receiver Operating Characteristic – Area Under the Curve), qui examine les taux de vrais positifs (TPR) et les taux de faux positifs (FPR). Des mesures supplémentaires incluent le score F1, le taux de vrais négatifs (TNR), les matrices de précision et de confusion.

Résultats

Les tests vérifient que le détecteur AI affiche une précision de détection élevée pour distinguer le texte écrit par l'homme du texte généré par l'IA tout en maintenant un faible taux de faux positifs.

Processus d'évaluation

En utilisant un système à deux départements, nous avons conçu notre processus d'évaluation pour garantir une qualité, des normes et une fiabilité de haut niveau. Nous avons deux départements indépendants qui évaluent le modèle : les équipes de science des données et d'assurance qualité. Chaque département travaille de manière indépendante avec ses données et outils d'évaluation et n'a pas accès au processus d'évaluation de l'autre. Cette séparation garantit que les résultats de l'évaluation sont impartiaux, objectifs et précis tout en capturant toutes les dimensions possibles des performances de notre modèle. De plus, il est essentiel de noter que les données de test sont séparées des données de formation et que nous testons nos modèles uniquement sur de nouvelles données qu'ils n'ont pas vues dans le passé.

Méthodologie

Les équipes d'assurance qualité et de science des données de Copyleaks ont rassemblé de manière indépendante une variété d'ensembles de données de test. Chaque ensemble de données de test se compose d'un nombre fini de textes. L'étiquette attendue (un marqueur indiquant si un texte spécifique a été écrit par un humain ou par une IA) de chaque ensemble de données est déterminée en fonction de la source des données. Les textes humains ont été collectés à partir de textes publiés avant l’avènement des systèmes modernes d’IA générative ou plus tard par d’autres sources fiables qui ont été à nouveau vérifiées par l’équipe. Les textes générés par l'IA ont été générés à l'aide d'une variété de modèles et de techniques d'IA générative.

Les tests ont été exécutés sur l'API Copyleaks. Nous avons vérifié si le résultat de l'API était correct pour chaque texte en fonction de l'étiquette cible, puis avons regroupé les scores pour calculer la matrice de confusion.

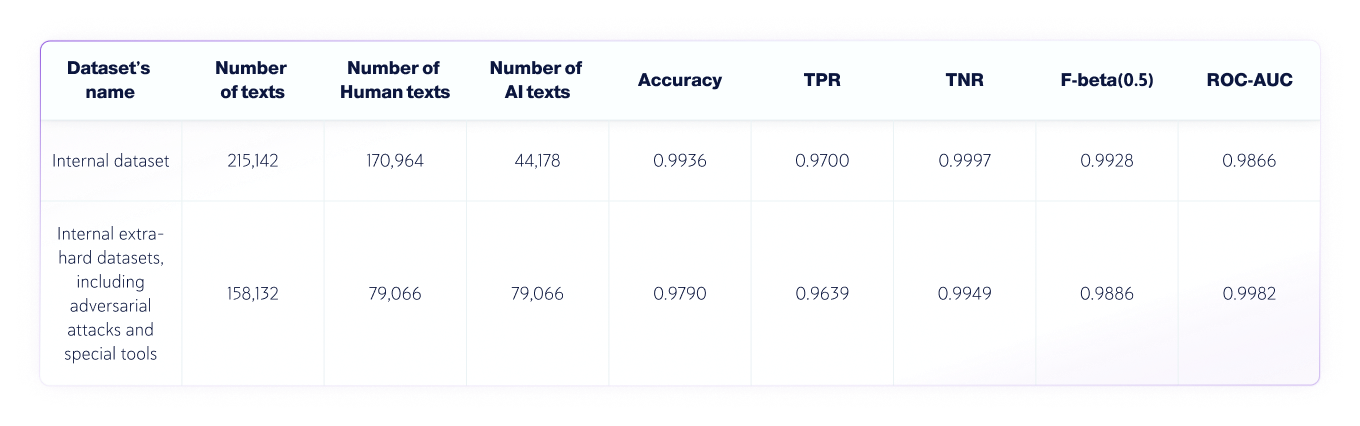

Résultats : équipe de science des données

L’équipe Data Science a réalisé le test indépendant suivant :

- La langue des textes était l'anglais, et 250 030 textes écrits par des humains et 123 244 textes générés par l'IA à partir de divers LLM ont été testés au total..

- La longueur des textes varie, mais les ensembles de données contiennent uniquement des textes d'une longueur supérieure à 350 caractères, le minimum accepté par notre produit.

Paramètres d'évaluation

Les métriques utilisées dans cette tâche de classification de texte sont :

1. Matrice de confusion : un tableau qui montre les TP (vrais positifs), FP (faux positifs), TN (vrais négatifs) et FN (faux négatifs).

2. Exactitude : la proportion de vrais résultats (à la fois vrais positifs et vrais négatifs) parmi le nombre total de textes qui ont été vérifiés.

3. TNR : la proportion de prédictions négatives exactes dans toutes les prédictions négatives.

Dans le contexte de la détection de l'IA, le TNR représente la précision du modèle sur les textes humains.

4. TPR (également connu sous le nom de rappel) : la proportion de résultats vraiment positifs dans toutes les prédictions réelles.

Dans le contexte de la détection de l'IA, le TPR correspond à la précision du modèle sur les textes générés par l'IA.

5. Score F-bêta : le moyenne harmonique pondérée entre précision et rappel, favorisant davantage la précision (car nous souhaitons favoriser un taux de faux positifs plus faible).

6. ROC-AUC : Évaluation du troquer entre TPR et FPR.

Ensembles de données combinés IA et humains

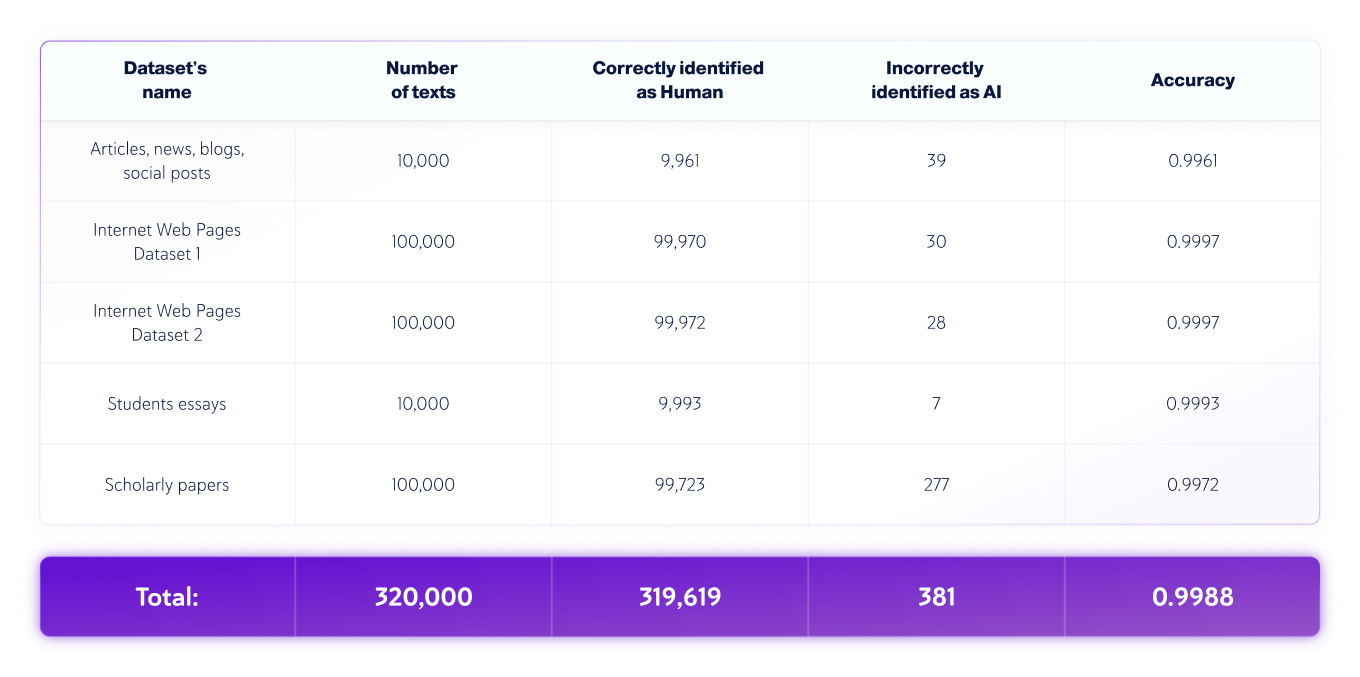

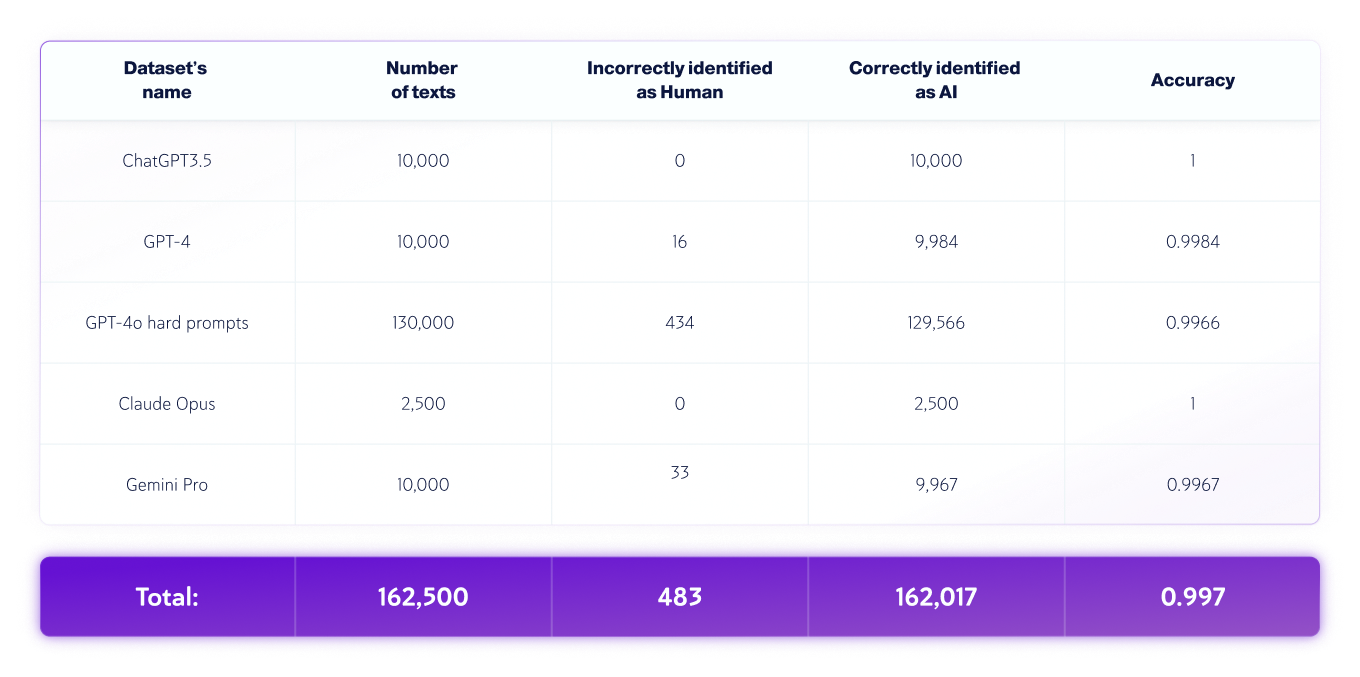

Résultats : équipe d’assurance qualité

L’équipe d’assurance qualité a effectué le test indépendant suivant :

- La langue du texte était l'anglais, et 320 000 textes écrits par des humains et 162 500 textes générés par l'IA à partir de divers LLM ont été testés au total..

- La longueur des textes varie, mais les ensembles de données contiennent uniquement des textes d'une longueur supérieure à 350 caractères, le minimum accepté par notre produit.

Ensembles de données réservés aux humains

Ensembles de données IA uniquement

*Les versions des modèles peuvent changer au fil du temps. Les textes ont été générés à l'aide de l'une des versions disponibles des modèles d'IA génératifs ci-dessus.

Analyse des erreurs de texte humaines et IA

Au cours du processus d'évaluation, nous identifions et analysons les erreurs commises par le modèle et produisons un rapport détaillé qui permettra à l'équipe de science des données de corriger les causes sous-jacentes de ces erreurs. Cela se fait sans exposer les erreurs elles-mêmes à l'équipe de science des données. Toutes les erreurs sont systématiquement enregistrées et classées en fonction de leur caractère et de leur nature dans le cadre d'un « processus d'analyse des causes profondes », qui vise à comprendre les causes sous-jacentes et à identifier les modèles répétés. Ce processus est toujours en cours, garantissant l'amélioration et l'adaptabilité de notre modèle dans le temps.

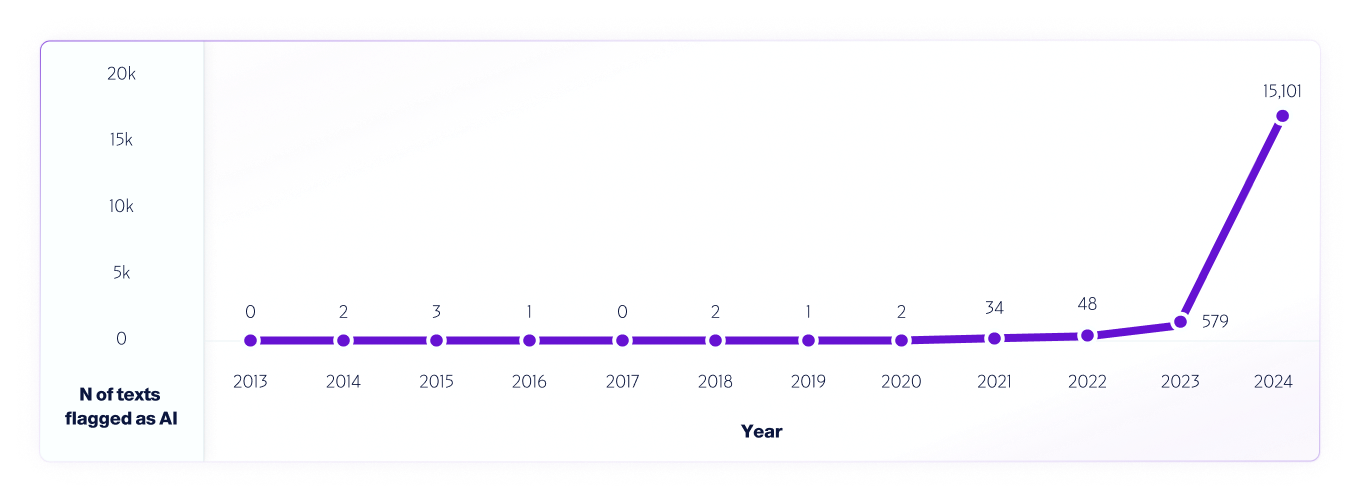

Un exemple d'un tel test est notre analyse de données Internet de 2013 à 2024 en utilisant notre modèle V4. WNous avons échantillonné 1 million de textes chaque année, à partir de 2013, en utilisant tous les faux positifs détectés entre 2013 et 2020, avant la sortie des systèmes d'IA, pour contribuer à améliorer davantage le modèle.

Semblable à la façon dont chercheurs du monde entier Nous avons déjà testé et continuons de tester différentes plates-formes de détecteurs d'IA pour évaluer leurs capacités et leurs limites, nous encourageons pleinement nos utilisateurs à effectuer des tests dans le monde réel. En fin de compte, à mesure que de nouveaux modèles seront publiés, nous continuerons à partager les méthodologies de test, la précision et d'autres considérations importantes à prendre en compte.