Ресурс

Оценка точности Copyleaks ИИ-детектор

Пошаговая методология

Мы считаем, что сейчас как никогда важно обеспечить полную прозрачность в отношении ИИ-детектора. точность, показатели ложных положительных и ложных отрицательных результатов, области для улучшения и многое другое для обеспечения ответственного использования и внедрения. Этот всесторонний анализ направлен на обеспечение полной прозрачности в отношении методологии тестирования модели V8 нашего AI Detector.

Дата теста: 15 января 2025 г.

Дата публикации: 18 февраля 2025 г.

Протестированная модель: V8

Команды Copyleaks Data Science и QA независимо друг от друга провели тестирование, чтобы обеспечить беспристрастные и точные результаты. Тестовые данные отличались от данных обучения и не содержали контента, ранее отправленного в AI Detector для обнаружения AI.

Тестовые данные состояли из текста, написанного человеком, полученного из проверенных наборов данных, и текста, сгенерированного ИИ из различных моделей ИИ. Тест был выполнен с помощью API Copyleaks.

Метрики включают общую точность, основанную на частоте правильной и неправильной идентификации текста, оценку F1, частоту истинно отрицательных результатов (TNR), частоту истинно положительных результатов (TPR), точность и матрицы путаницы.

Тестирование подтверждает, что AI Detector демонстрирует высокую точность обнаружения, различая текст, написанный человеком, и текст, сгенерированный искусственным интеллектом, сохраняя при этом низкий уровень ложных срабатываний.

Процесс оценки

Используя систему из двух отделов, мы разработали наш процесс оценки, чтобы гарантировать высочайшее качество, стандарты и надежность. У нас есть два независимых отдела, оценивающих модель: команды по науке о данных и по контролю качества. Каждый отдел работает независимо со своими данными и инструментами оценки и не имеет доступа к процессу оценки другого отдела. Такое разделение гарантирует, что результаты оценки будут беспристрастными, объективными и точными, при этом охватывая все возможные измерения производительности нашей модели. Кроме того, важно отметить, что данные тестирования отделены от данных обучения, и мы тестируем наши модели только на новых данных, которые они не видели в прошлом.

Методология

Команды Copyleaks' QA и Data Science независимо друг от друга собрали множество тестовых наборов данных. Каждый тестовый набор данных состоит из конечного числа текстов. Ожидаемая метка — маркер, указывающий, был ли конкретный текст написан человеком или ИИ — каждого набора данных определяется на основе источника данных. Человеческие тексты были собраны из текстов, опубликованных до появления современных генеративных систем ИИ или позже из других надежных источников, которые были снова проверены командой. Тексты, сгенерированные ИИ, были сгенерированы с использованием различных моделей и методов генеративного ИИ.

Тесты проводились с использованием API Copyleaks. Мы проверили, был ли вывод API правильным для каждого текста на основе целевой метки, а затем агрегировали баллы для расчета матрицы путаницы.

Результаты: Команда по науке о данных

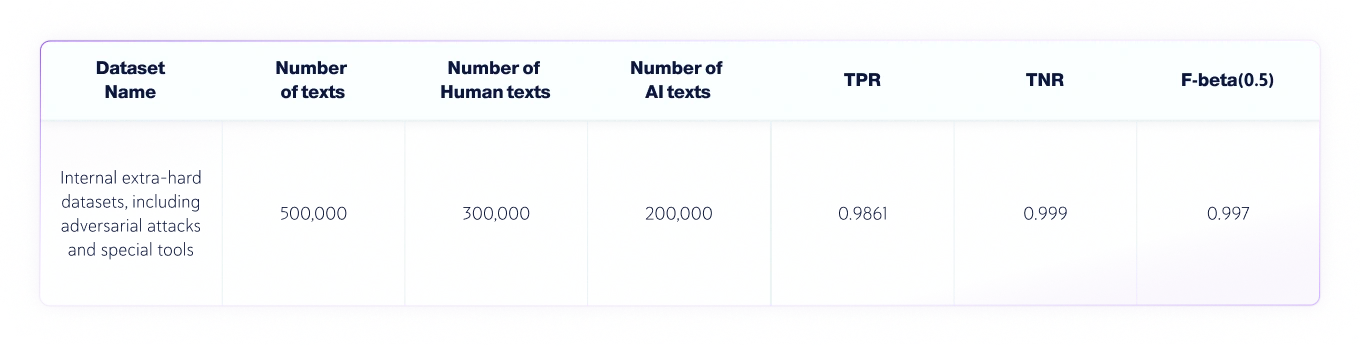

Команда Data Science провела следующий независимый тест:

- Языком текстов был английский, всего было протестировано 300 000 текстов, написанных человеком, и 200 000 текстов, сгенерированных искусственным интеллектом, от различных LLM..

- Длина текста может быть разной, но наборы данных содержат только тексты длиной более 350 символов — это минимум, который принимает наш продукт.

Метрики оценки

Метрики, которые используются в этой задаче классификации текста:

1. Матрица ошибок: таблица, в которой показаны TP (истинно положительные результаты), FP (ложно положительные результаты), TN (истинно отрицательные результаты) и FN (ложно отрицательные результаты).

2. Точность: доля истинных результатов (как истинно положительных, так и истинно отрицательных) среди общее количество текстов которые были проверены.

3. TNR: Доля точных отрицательных прогнозов в все негативные прогнозы.

В контексте обнаружения ИИ TNR — это точность модели применительно к текстам, написанным человеком.

4. TPR (также известный как отзыв): доля истинно положительных результатов в все фактические прогнозы.

В контексте обнаружения ИИ TPR — это точность модели в текстах, сгенерированных ИИ.

5. Оценка F-бета: взвешенное гармоническое среднее между точностью и полнотой, в большей степени отдающее предпочтение точности (поскольку мы хотим добиться более низкого уровня ложных срабатываний).

Объединенные наборы данных ИИ и человека

Результаты: команда контроля качества

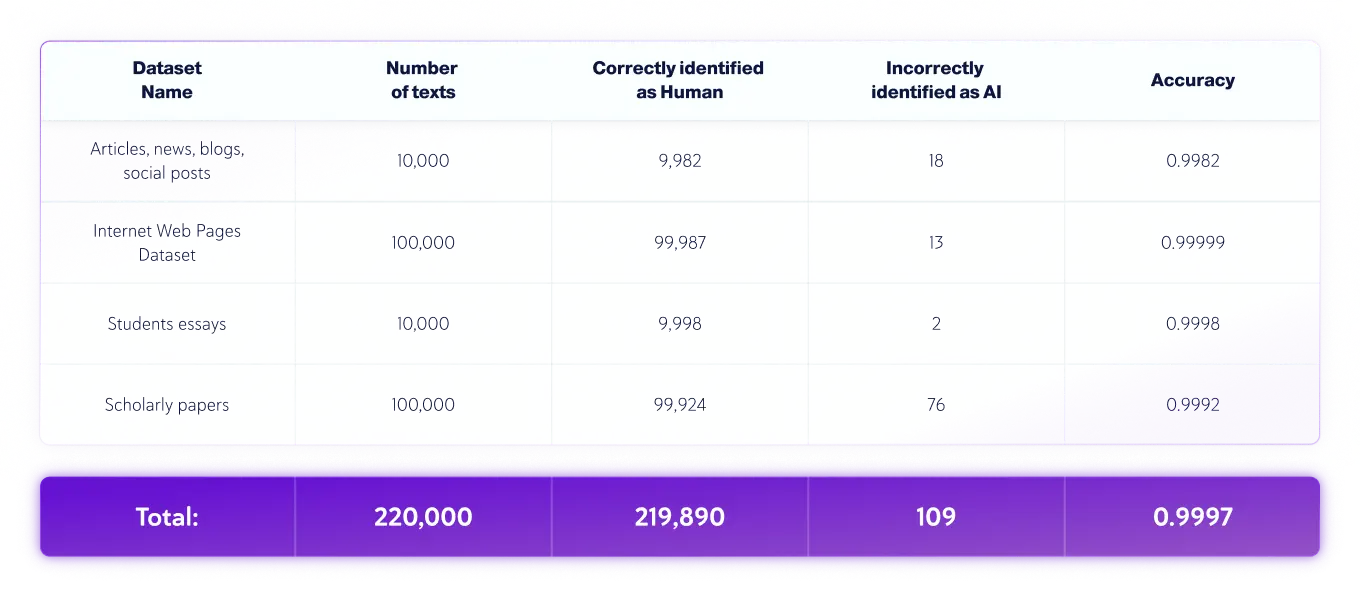

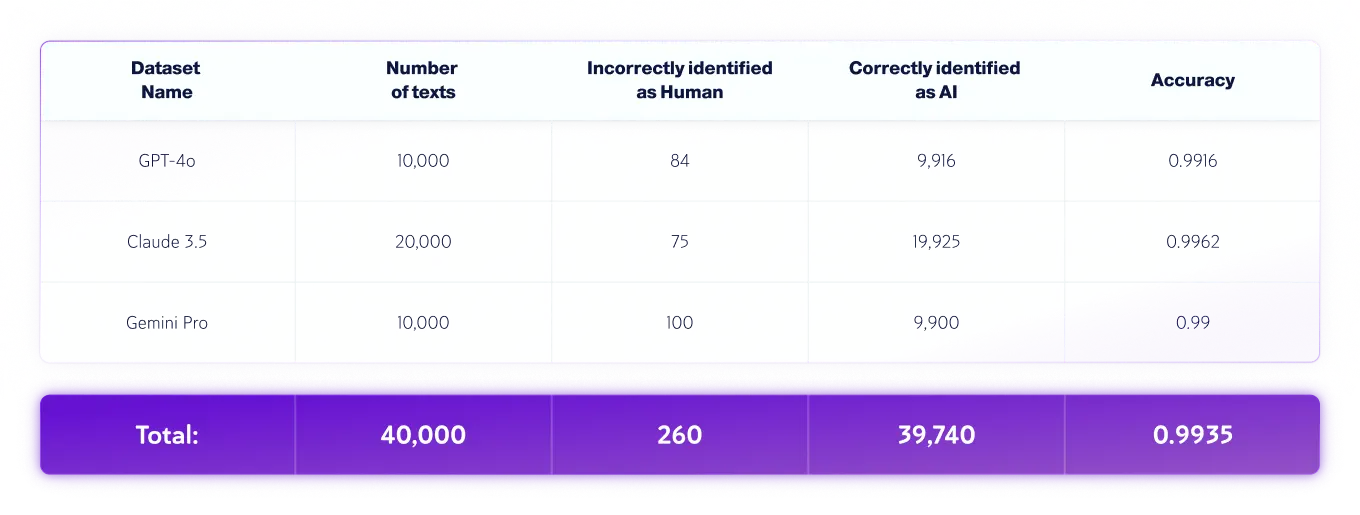

Команда QA провела следующее независимое тестирование:

- Языком текстов был английский, всего было протестировано 220 000 текстов, написанных человеком, и 40 000 текстов, сгенерированных искусственным интеллектом, от различных LLM..

- Длина текста может быть разной, но наборы данных содержат только тексты длиной более 350 символов — это минимум, который принимает наш продукт.

Наборы данных, предназначенные только для людей

Наборы данных только для ИИ

*Версии моделей могут меняться со временем. Тексты были сгенерированы с использованием одной из доступных версий вышеуказанных генеративных моделей ИИ.

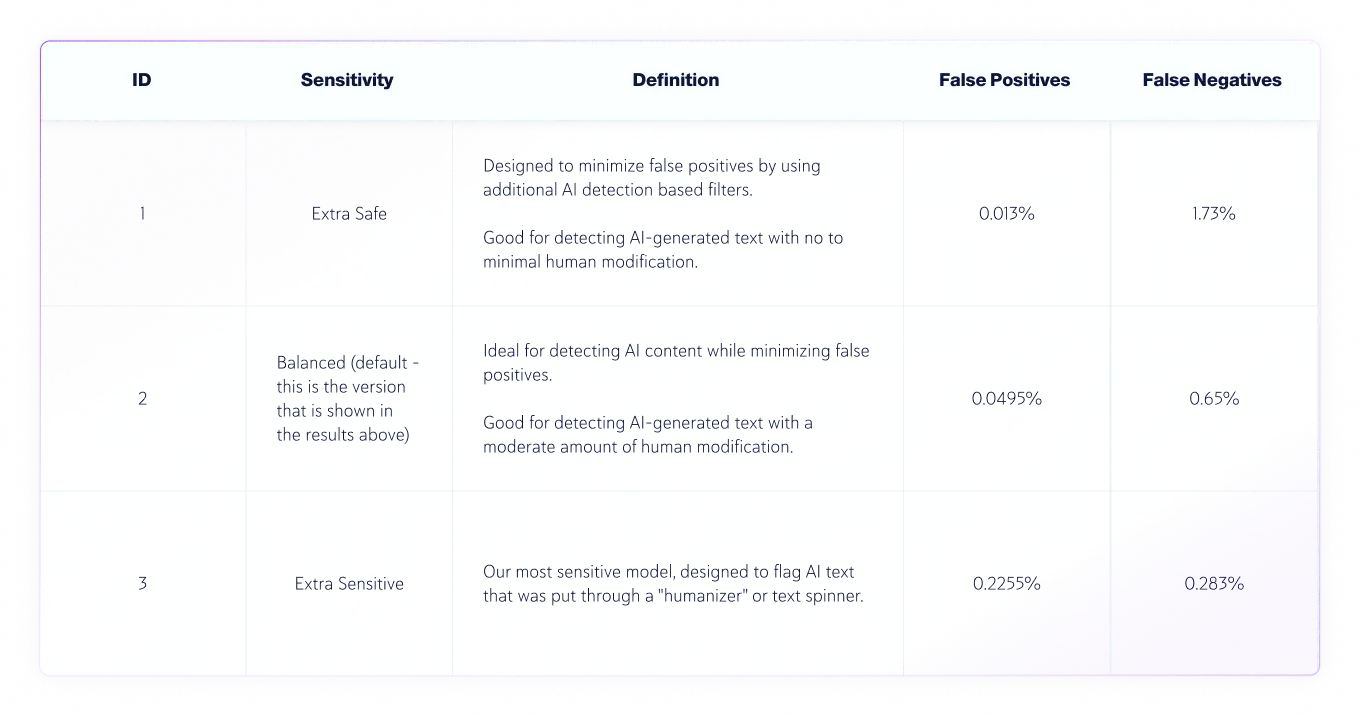

Уровни чувствительности

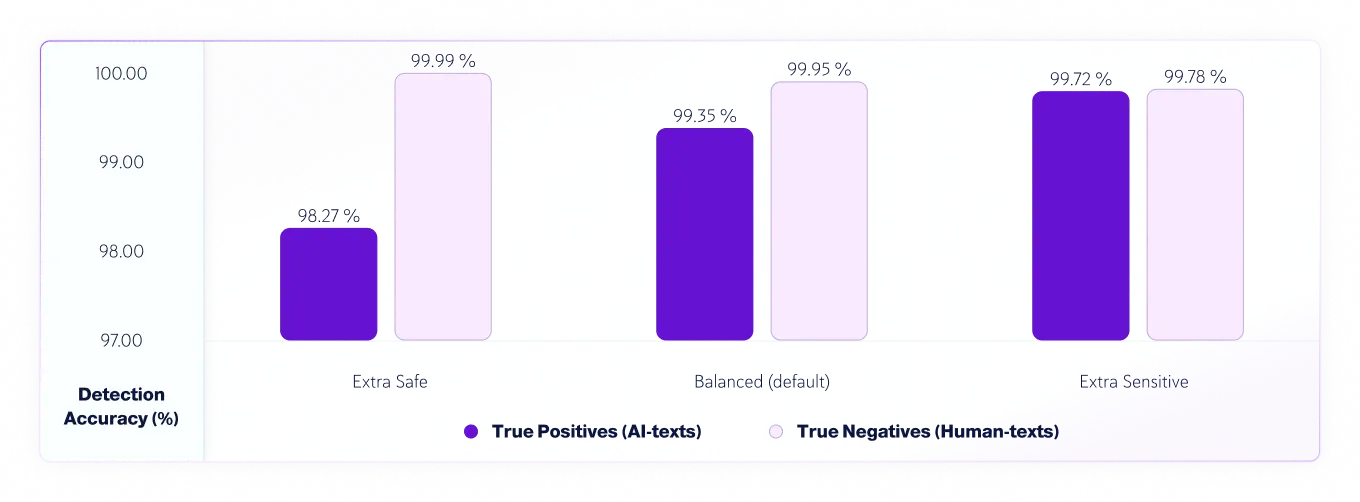

Начиная с версии 7.1 у нас есть 3 уровня чувствительности для модели обнаружения ИИ. Вот результаты тестирования уровней чувствительности модели v8.

Точность истинных положительных результатов (тексты ИИ) и истинных отрицательных результатов (тексты человека) по чувствительности

Анализ текстовых ошибок человеком и искусственным интеллектом

В процессе оценки мы выявили и проанализировали неверные оценки, сделанные моделью, и создали подробный отчет, который позволит команде по науке о данных исправить основные причины. Это делается без раскрытия неверных оценок команде по науке о данных. Все ошибки систематически регистрируются и классифицируются на основе их характера и природы в «процессе анализа первопричин», который направлен на понимание основных причин и выявление повторяющихся закономерностей. Этот процесс всегда непрерывен, обеспечивая постоянное улучшение и адаптивность нашей модели с течением времени.

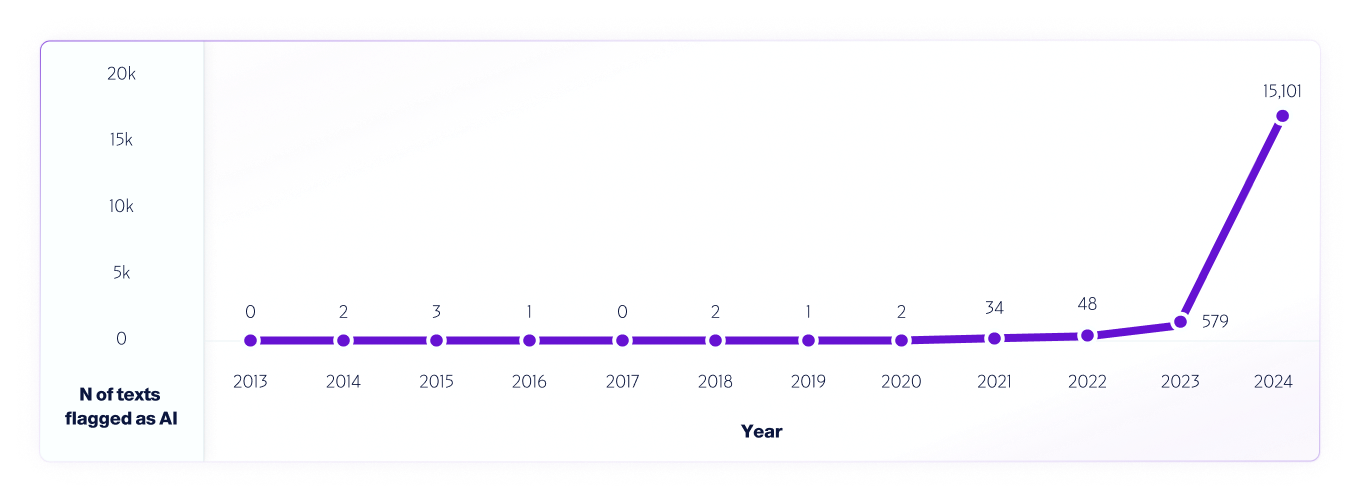

Одним из примеров такого теста является наш анализ интернет-данных с 2013 по 2024 год с использованием нашей модели V4. Мы отобрали 1 млн текстов за каждый год, начиная с 2013 года, используя любые ложные срабатывания, обнаруженные с 2013 по 2020 год, до выпуска систем ИИ, чтобы помочь улучшить модель дальше.

Подобно тому, как исследователи по всему миру тестируем и продолжаем тестировать различные платформы детекторов ИИ, чтобы оценить их возможности и ограничения, мы полностью призываем наших пользователей проводить тестирование в реальных условиях. В конечном итоге, по мере выпуска новых моделей, мы продолжим делиться методиками тестирования, точностью и другими важными соображениями, которые следует учитывать.